相信自媒体上炒作AI代理人都被忽悠了

2025年3月9日

作者:Austin Starks

来源:翻译

我在刷领英上时,总能看到一些产品经理夸大宣传所谓的AI代理(AI Agents),这种炒作纯属胡言乱语。

在你急着跳到评论区之前,请听我说:我并非怀有偏见。

我在ChatGPT出现前就已经接触大型语言模型,那时还只是OpenAI网站上的GPT-3,它仅仅能预测句子中的下一个词(与现在我们熟悉的对话界面截然不同)。

我曾从零构建AI应用并训练过各类AI模型。

我在世界顶尖AI和计算机科学学府卡内基梅隆大学修读过深度学习课程,并获得了该校硕士学位。

然而,每当我在TikTok上刷到又一个相关视频时,我都不禁感到尴尬,想起那些曾经"Web 3将如何变革互联网"的夸大宣传。

我敢说,这些不过是机器人账号、无知的非技术人员和OpenAI为获取更多资金而制造的炒作。试问,你认识几位已经发布过能用于生产环境的AI代理的软件工程师?

没错,一个也没有。

下面我来解释为什么这些人为炒作纯属胡言乱语。

什么是"AI代理"?

代理( Agents)在人工智能领域其实由来已久。自ChatGPT问世以来,它被定义为一种结构化的大型语言模型,能够自主推理并完成任务。

这种模型理论上可以通过强化学习进行微调,但实际应用中,人们往往直接使用OpenAI的GPT、Google的Gemini或Anthropic的Claude。

代理与普通语言模型的根本区别在于,代理能够自主完成任务。

举个例子:

我创立了一个算法交易和金融研究平台,NexusTrade。

假设我想停止向外部数据供应商付费获取美国公司的基本面数据。

使用传统语言模型时,我需要编写与之交互的代码,流程大致如下:

- 构建一个爬取SEC网站的脚本或利用GitHub仓库获取公司信息(遵循其服务条款中每秒10个请求的限制)

- 使用pypdf等Python库将PDF转换成文本

- 将文本发送给大型语言模型进行数据格式化

- 验证响应结果

- 将数据保存至数据库

- 对所有公司重复上述过程

而使用AI代理,理论上你只需说:爬取所有美国公司过去和未来的历史数据,并保存到MongoDB数据库

它可能会问你一些澄清性问题,比如你对数据模式有何构想,或者哪些信息最为重要。

但核心理念是:你提供目标,它自主完成整个任务。

听起来好得难以置信,对吧?

那是因为确实如此。

AI代理在实践中的问题

假如最小、最便宜的语言模型是免费的,且强大如Claude 3.7,还能在任何AWS T2实例上本地运行,那么这篇文章的基调将截然不同。

本文将不是批评,而是警告。注意这个前提。

然而,现实是,AI代理在实际应用中根本不可行,原因如下:

1. 小型模型根本不够强大

代理的核心问题在于它们依赖大型语言模型。

更准确地说,它们依赖高质量的模型。

除Flash外最便宜的大型语言模型GPT-4o mini,就其价格而言确实令人惊叹。

但它简单来说不够强大,无法完成现实世界中的代理任务。

无论你如何精心设计提示,它都会偏离轨道,忘记目标,或犯一些低级错误。

如果将其部署到生产环境,你的业务将付出代价。

当大型语言模型出错时,除非你额外构建验证框架(可能也是基于LLM的),否则几乎无法察觉。开始时的一个小错误就会导致所有后续流程崩溃。

在实际应用中,情况是这样的:

2. 错误累积效应

假设你使用GPT-4o-mini执行AI代理工作。

你的AI代理将为公司提取财务信息的任务分解为多个子任务。假设它正确完成每个子任务的概率是90%。

这样一来,错误就会累积。

即使一个任务只有中等难度,包含四个子任务,最终输出正确的概率也极低。

分析如下:

- 完成一个子任务的概率是90%

- 完成两个子任务的概率是0.9×0.9=81%

- 完成四个子任务的概率是66%

明白我的意思了吗?

为缓解这一问题,你会考虑使用更强大的语言模型。

更强大的模型可能将每个子任务的准确率提高到99%。四个子任务后,最终准确率达到96%。好多了(但仍非完美)。

关键是,切换到这些更强大的模型会导致成本飙升。

3. 成本爆炸

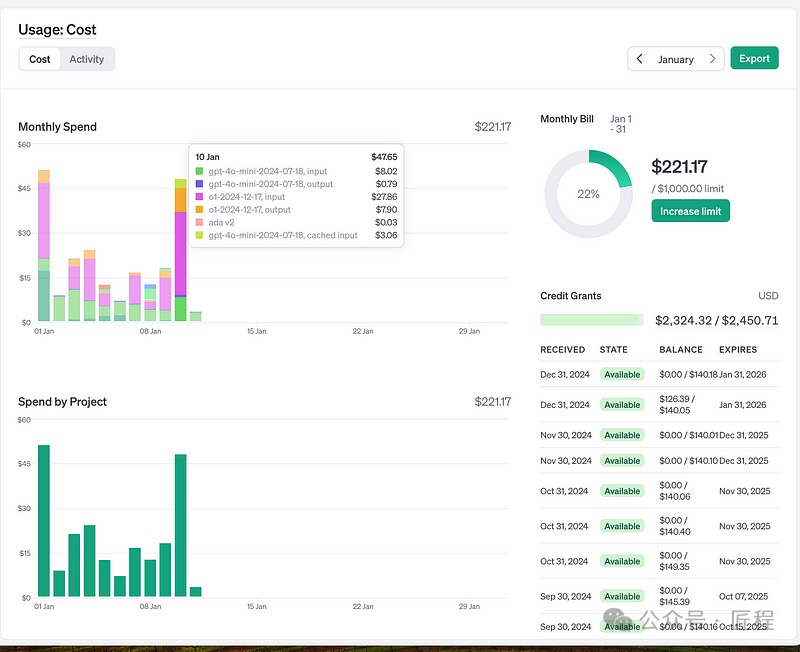

图:OpenAI的o1模型与GPT-4o-mini之间的成本差异

一旦切换到更强大的OpenAI模型,你会发现成本如何飙升。

图中粉色和橙色线是OpenAI的o1成本。我每天可能只使用它4-5次,专门用于极其复杂的任务,如生成股票分析的有效语法查询。

浅绿色和深蓝色线是GPT-4o-mini的成本。这个模型每天处理数百个请求,但最终成本仅为o1的一小部分。

此外,即使做了这些,你仍需验证最终输出结果。出于同样原因,你将使用更强大的模型进行验证。

现在明白为什么我认为这是OpenAI的阴谋了吧?

最后,将工作方式从代码转变为模型会产生巨大的副作用。

4. 输出结果难以预测和控制

使用AI代理,你的整个工作范式转变为类数据科学的方法。

你不再编写确定性代码(这种代码在任何地方运行成本低廉,可以在Arduino上运行,或者实际上是AWS的T2微型实例上),而是为运行在GPU集群上的模型编写非确定性提示词。

如果你"幸运",你可能自己运行GPU上的微调模型,但仅为维护执行简单任务的AI代理,成本依然高昂。

如果不幸,你将完全依赖OpenAI;一旦尝试迁移,你的提示词将完全失效,而当你用其API运行关键业务流程时,他们可以慢慢提高价格。

在你说"可以使用OpenRouter轻松切换模型"之前,再想想。

Anthropic的模型输出与OpenAI的完全不同。

因此,为了通过另一家大模型供应商获得微小的性能提升,你必须重新设计整个提示工程栈,这将耗费巨资。

现在看出问题所在了吗?

结 论

几乎可以肯定,每当我看到关于AI代理的帖子时,它都来自没有实际使用过大语言模型的人。

可想而知,这真令人恼火。

我并非说AI代理毫无用处。几年后,AI代理甚至可能有价值,帮助工程师编写简单代码。(注:不赞成,编程领域的AI代理目前非常强大了)

但没有任何理性的公司会用一套极其昂贵、易出错的AI代理替代其运营团队来运行业务关键流程。

因为AI大模型的能力,依赖底层大模型能力提升。

如果有公司尝试这么做,我们会亲眼目睹他们如何在两年内破产。他们将成为商业教科书中的反面教材,而OpenAI将增加10亿美元的收入。

记住我的话。

公众号:「匠程」