2种方法让本地部署的DeepSeek R1 实现联网搜索功能

2025年2月6日

这篇文章将讲解如何让本地部署的 DeepSeek R1实现联网搜索。也会顺带提到如何本地部署 DeepSeek R1(本地部署是实现联网搜索的前提)。

本地部署适合不想/不方便联网、不想透露自己的数据的场景。

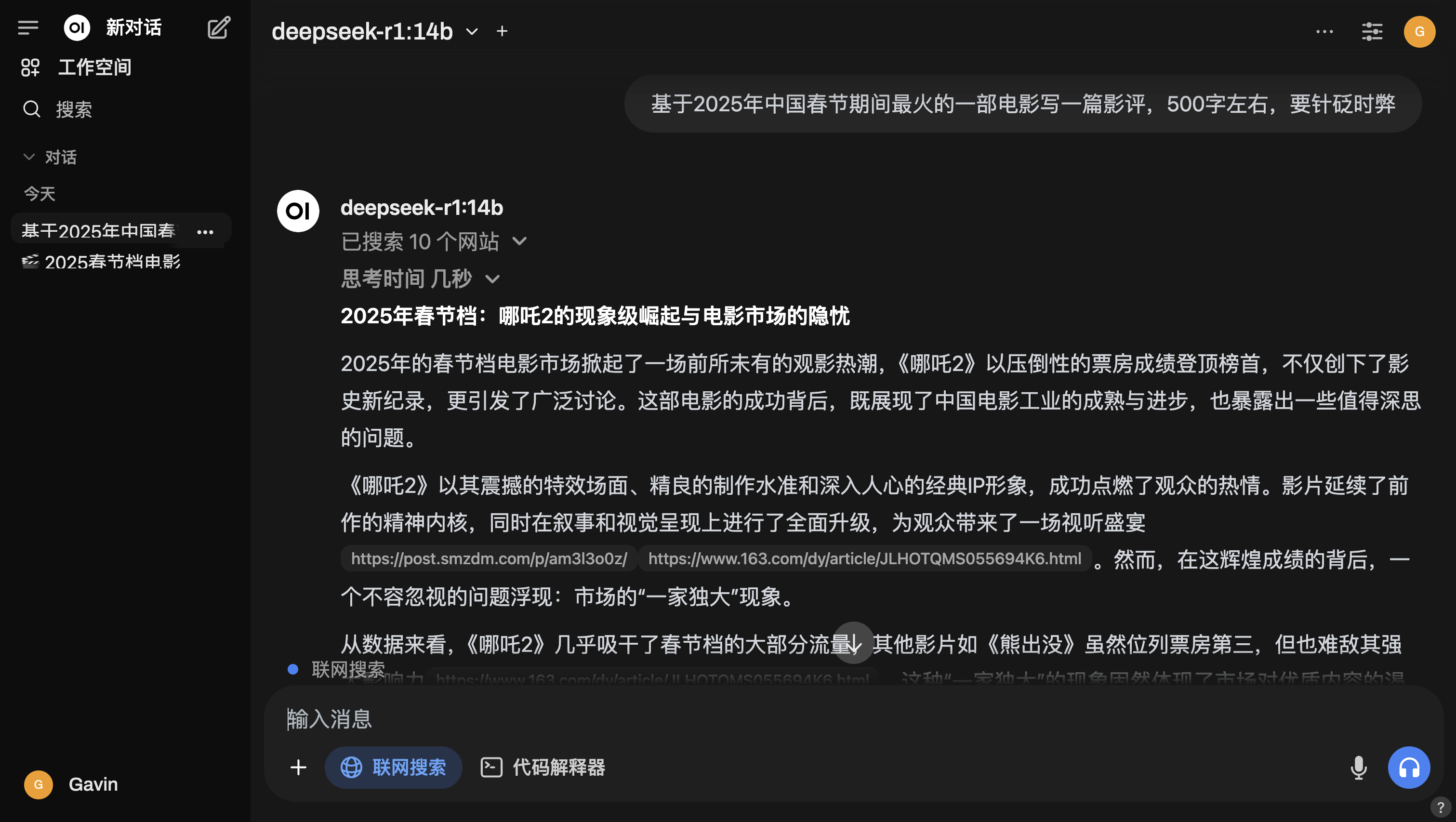

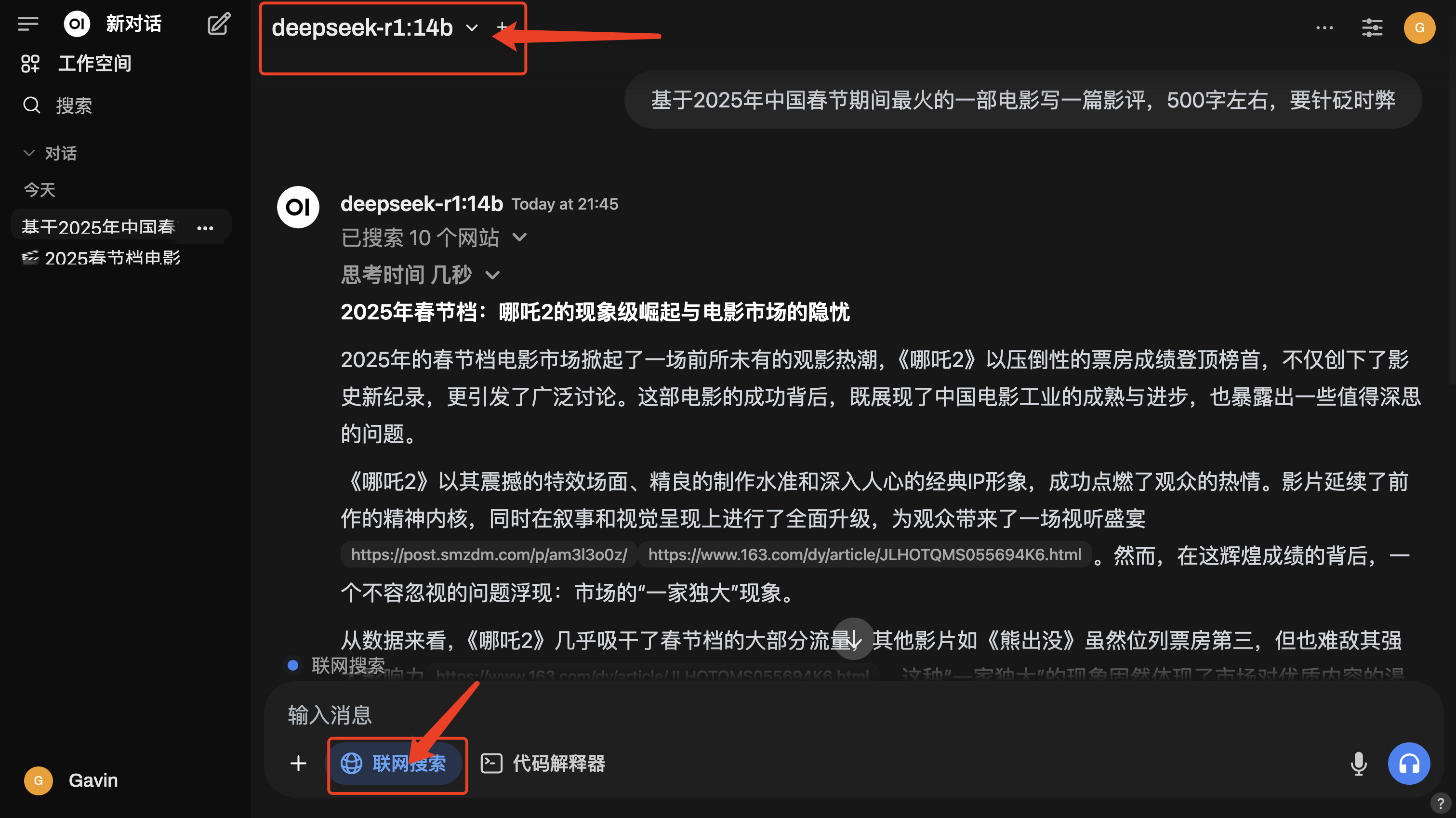

先看效果。在没有说明选择哪部电影下,AI选择了《哪吒2》,思考后给出了影评。效果虽然不如DeepSeek官网大模型,但是一些场景够用了。

一种方式是使用插件Page Assist,支持 Chromium 的浏览器,如 Chrome、Brave 和 Edge,以及 Firefox。

一种方式是使用Ollama + Open WebUI。这种方法支持配置本地知识库,接入自定义提示词,功能更丰富,个性化程度高。

开始之前,请确保你的电脑内存至少 8GB(推荐 16GB),硬盘空余空间 10GB 左右,并且有稳定的网络连接。

方法一:插件 Page Assist

第一步:安装 Ollama

访问 Ollama 官网(网址:ollama.com),按照指引下载并安装 Ollama。

【对于不方便下载 Ollama 的伙伴 ,我已经准备好了安装包,后台回复“安装包”即可获取】

第二步:使用 Ollama 下载deepseek-r1

1)先在电脑上点击 ollama 图标打开 ollama。

2)接着使用 Ollama 下载deepseek-r1,先打开终端:

- 苹果电脑:搜索框输入「终端」,打开终端APP。

- window电脑:按下

Win + R打开“运行”对话框;输入cmd,然后按Enter。

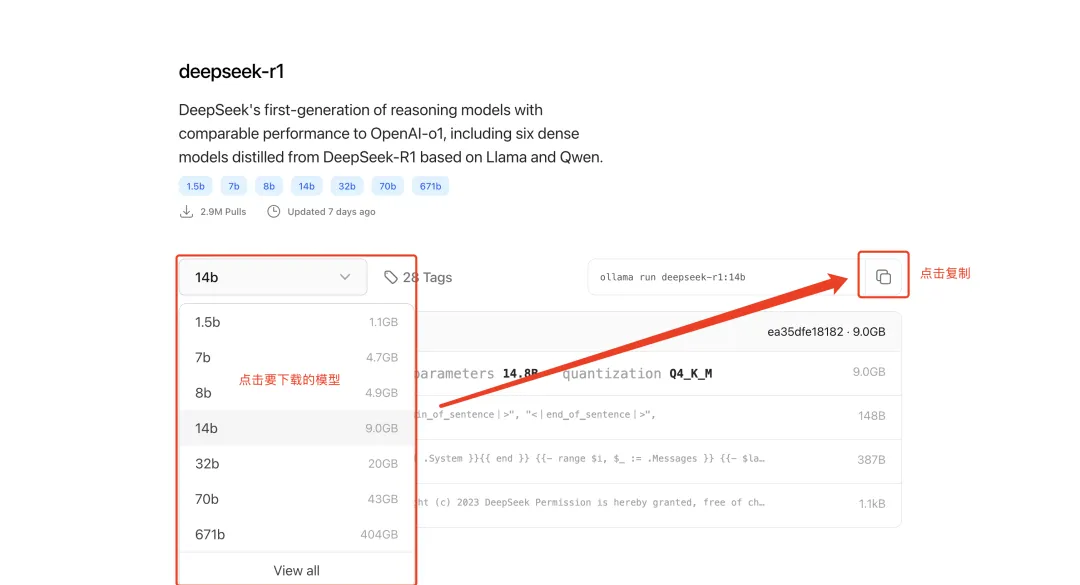

3)在这个页面 https://ollama.com/library/deepseek-r1 选择适合电脑内存的,建议最好选择8B及以上的。

复制命令粘贴在终端,我选择的是14B的,终端粘贴ollama run deepseek-r1:14b。

等待下载完成(注:下图用8B演示,因为之前下载过14B,无法再出现下图)

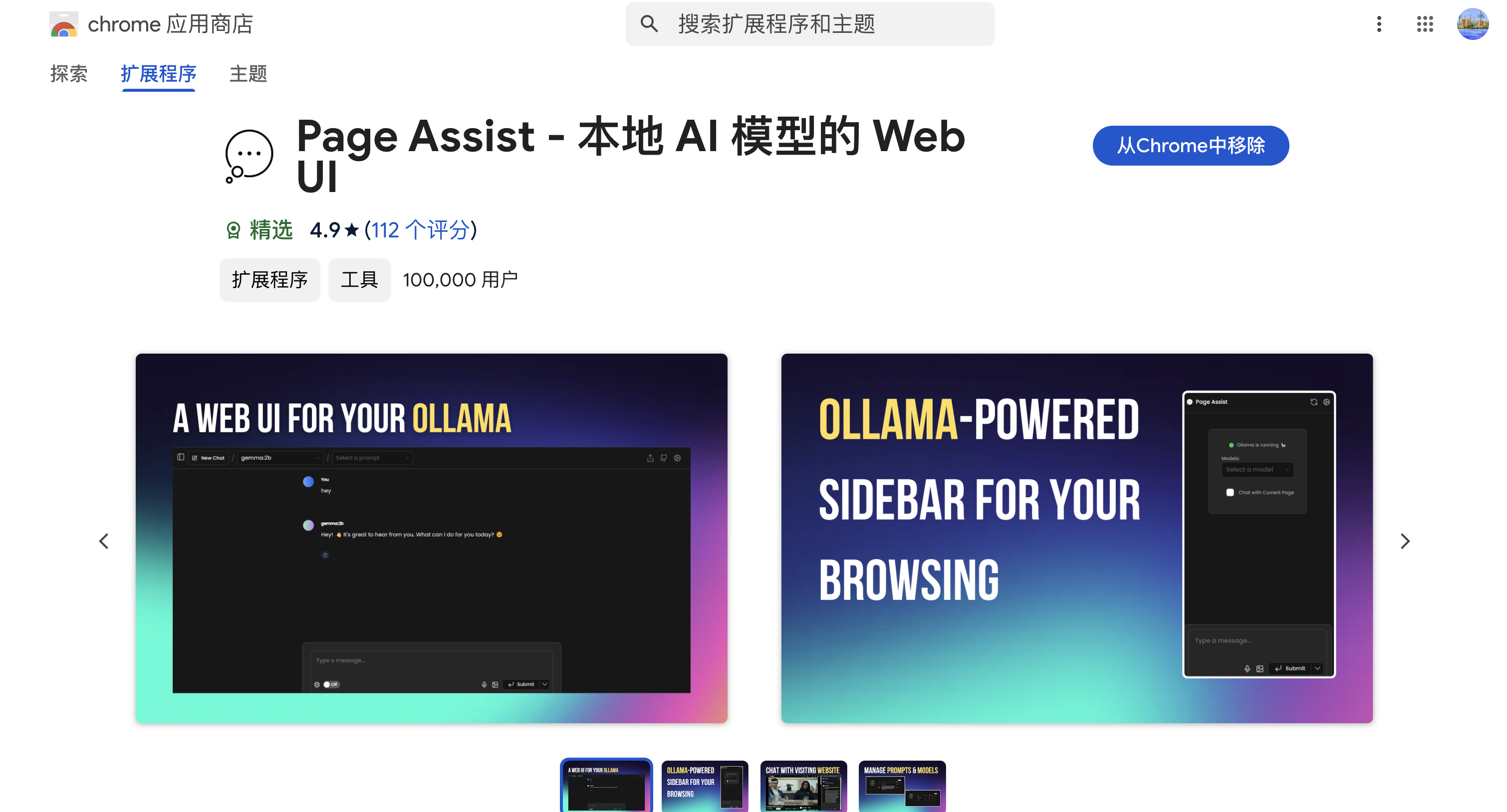

第三步:安装插件Page Assist

插件Page Assist 支持 Chromium 的浏览器,如 Chrome、Brave 和 Edge,以及 Firefox。

我使用的是谷歌浏览器,在谷歌运用商店搜索Page Assist,并且安装。其他浏览器可根据实际情况操作。

第四步:使用联网功能

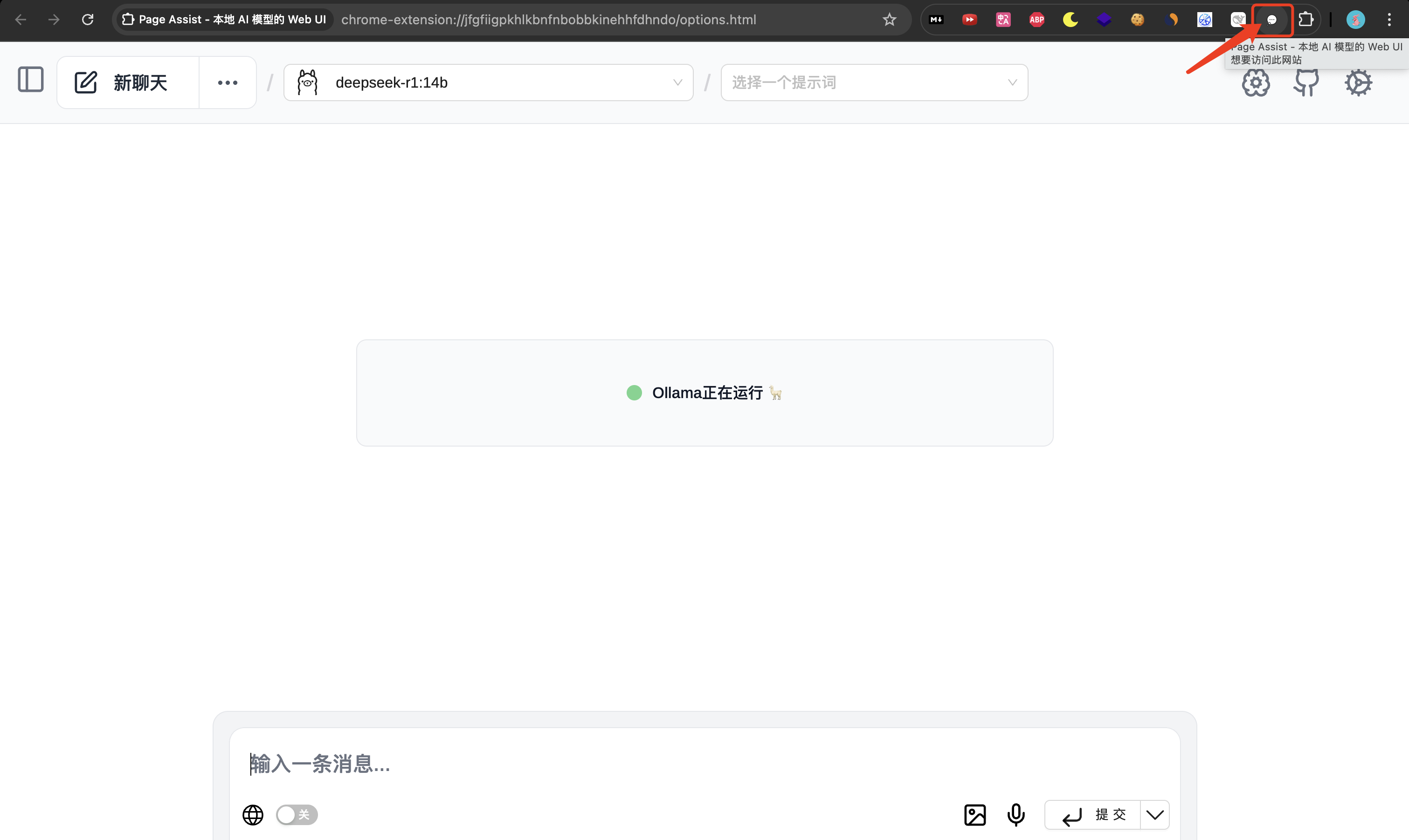

确保你的 Ollama 始终是打开的(可以在电脑上看到羊驼)。

在浏览器中点击插件图标,打开页面。

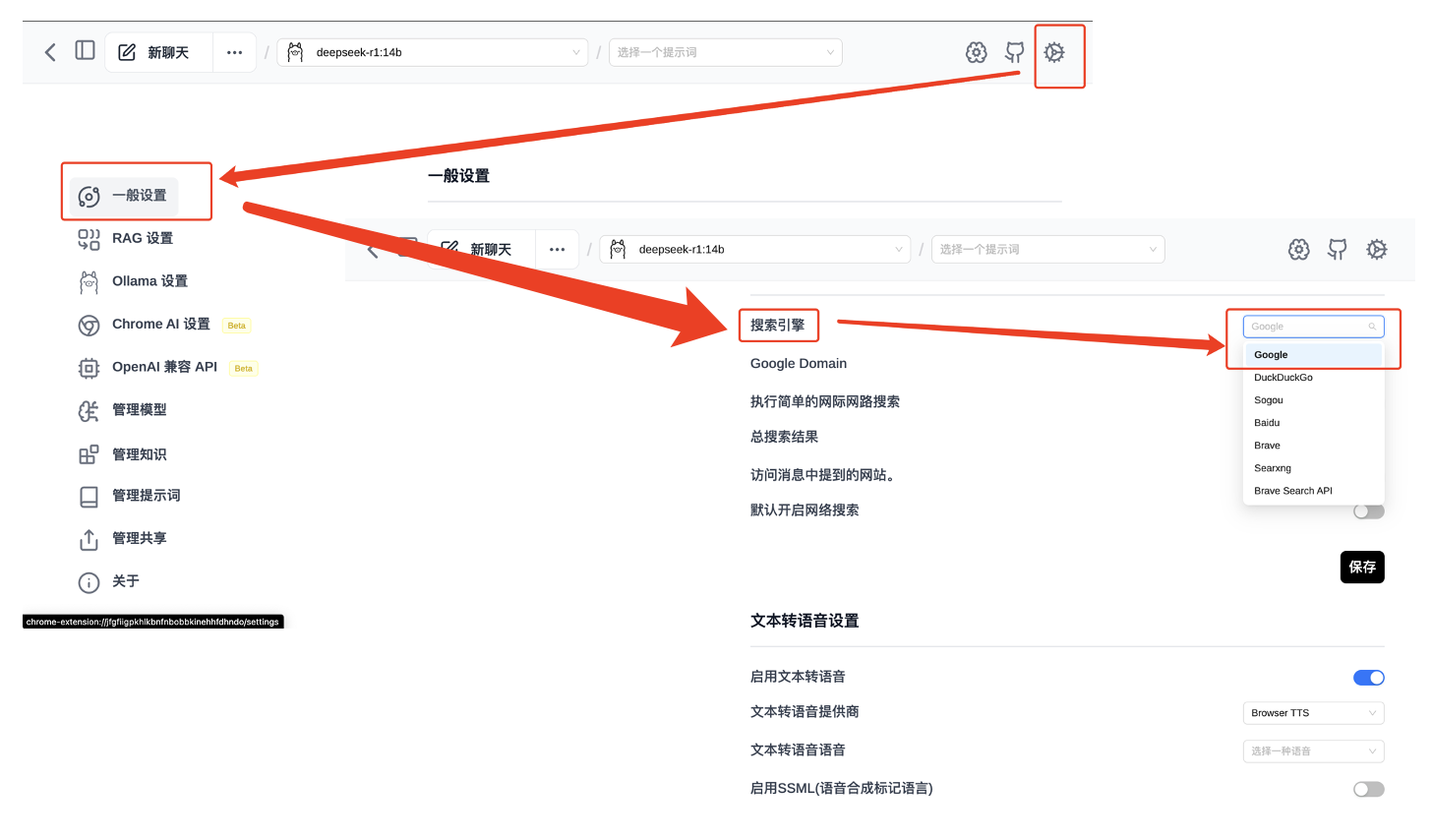

依次点击右上角的齿轮按钮-一般设置-搜索引擎-选择一个搜索引擎。

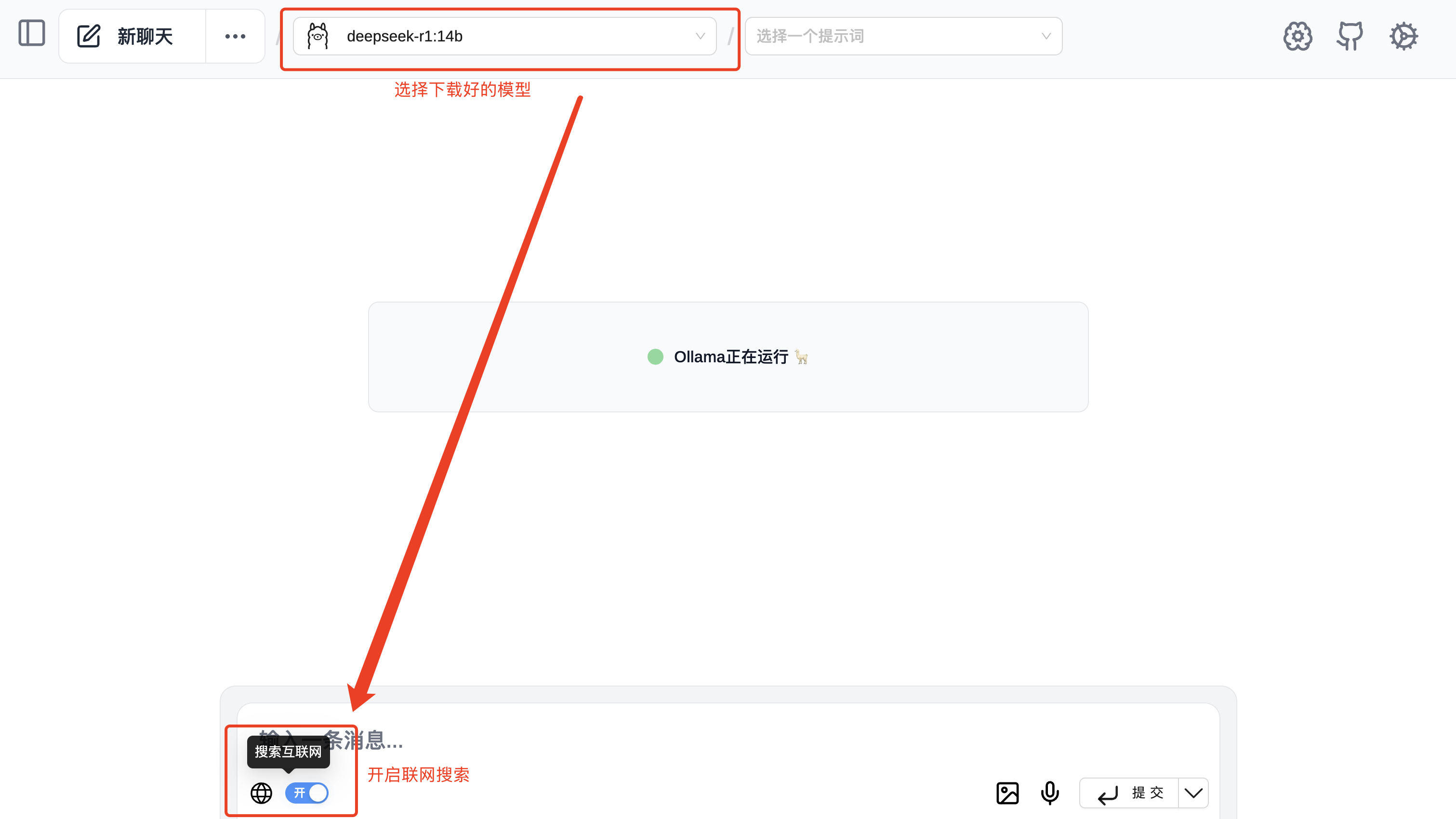

回到首页,选择下载好的模型,开启联网搜索,即刻使用带联网搜索功能的本地模型。

方法二:Ollama + Open WebUI

第一步:安装 Ollama

同上。

第二步:使用 Ollama 下载deepseek-r1

同上。

第三步:安装Open WebUI

Open WebUI是一个大模型的运行界面,相当于包裹大模型文件,让大模型更易于用户操作的皮肤。

安装方式一:一键安装(推荐)

- 访问 Docker官网(网址:https://www.docker.com/products/docker-desktop/),下载安装 Docker Desktop。

- 启动 Docker Desktop。

- 打开终端(Windows 按 Win+R 输入 cmd,Mac 打开终端),输入:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data ghcr.io/open-webui/open-webui:main

安装方式二:轻量安装

打开终端,输入:

pip install open-webui

open-webui --host 0.0.0.0 --port 3000

如果提示找不到 pip 命令,需要先安装 Python。访问 Python官网 下载安装即可。

第四步:配置联网功能

打开浏览器访问 http://localhost:3000,点击注册账号,账号密码自己填就可以。

登录后,点击右上角的“设置”-“管理员设置”,按照第三张图启动联网配置,并且“保存”。

第五步:开始使用

回到首页后,上面选择下载好的DeepSeek-R1模型,选择“联网搜索”,即可使用。

我输入“基于2025年中国春节期间最火的一部电影写一篇影评,500字左右,要针砭时弊”,选择了哪吒2。

日常使用说明

日常启用

- 确保 Ollama 在运行,Ollama运行时,电脑上可以看到图标。(非常重要)。

- 使用插件直接打开插件即可。

- 使用Ollama + Open WebUI:

- 使用第一种安装方式,直接访问 http://localhost:3000

- 使用第二种安装方式,先在终端运行

open-webui --host 0.0.0.0 --port 3000,再访问http://localhost:3000。

常见问题

如果打不开网页,检查:

- Ollama 是否正在运行

- Docker Desktop 是否启动(如果使用第一种安装方式)

- 是否正确运行了 open-webui 命令(如果使用第二种安装方式)

现在,你已经拥有了一个既能独立运行,又能联网搜索的 AI 助手!

小红书: 小匠 AI

公众号:匠程

交流合作+V:a52947593